Belén Gache

Algunas consideraciones sobre la relación entre Inteligencia Artificial y creatividad

Algunas consideraciones sobre la relación entre Inteligencia Artificial y creatividad

A principios del mes de octubre, fui invitada a participar en una mesa redonda en el III FORO CULTURA EN DIGITAL, organizado por la Fundación Telefónica en La Térmica, Málaga. La dinámica de la mesa era dialógica y no se requería la exposición de un paper. De todos modos, escribí este texto para la ocasión.

ALGUNAS CONSIDERACIONES SOBRE LA RELACION ENTRE INTELIGENCIA ARTIFICIAL Y CREATIVIDAD

A principios del mes de octubre, fui invitada a participar en una mesa redonda en el III FORO CULTURA EN DIGITAL, organizado por la Fundación Telefónica en La Térmica, Málaga. La dinámica de la mesa era dialógica y no se requería la exposición de un paper. De todos modos, escribí este texto para la ocasión.

POESÍA Y TECNOLOGÍA ENTRELAZADAS

El pasado 2 de agosto, le pedí al chat GPT que escribiera un poema como si fuera yo, Belén Gache, y compuso este texto titulado “Poesía y tecnología entrelazadas”:

El chat compuso un poema de cinco estrofas de cuatro versos cada una, con rima consonante más o menos ABAB y con versos más o menos alejandrinos, es decir, de catorce sílabas cada uno. Aunque había captado la temática de mi trabajo, evidentemente había compuesto un poema remedando una tradicional estructura clásica muy lejana a mis propuestas.

Dado que vengo del entorno de la literatura, me referiré hoy principalmente a los programas de IA de base lingüística más que a los visuales. Dada la codificación fuerte que posee el lenguaje, la naturaleza de los primeros es completamente diferente a la de los segundos. Aunque también es cierto que los segundos no dejan de utilizar el lenguaje, por ejemplo, con el tagging. Estos programas utilizan tecnologías que convierte texto a imagen e imagen a texto y poseen galerías de imágenes catalogadas según diferentes etiquetas.

Además, es también importante subrayar que, aunque estos programas suelen denominarse programas de AI, en realidad se trata de “simuladores de lenguaje natural” dado que no realizan tareas inteligentes como podrían ser el aprendizaje o el razonamiento. Lo que hacen estos programas es analizar y correlacionar grandes conjuntos de datos, examinarlos y crear patrones a partir de los mismos. Cuando hablamos de “aprendizaje” o “entrenamiento” nos estamos refiriendo en realidad a determinados sesgos matemáticos utilizados para reforzar ciertos parámetros y así lograr resultados preferidos. La IA comercial no evoluciona, ni se modifica a sí misma, ni puede hacerlo básicamente porque ningún fabricante lanzaría al mercado un dispositivo que actuara de forma impredecible. Mientras que, en un entorno de investigación, la AI sí puede automodificarse, autorreplicarse y utilizar mutaciones y elementos aleatorios, estas características son inútiles para las aplicaciones comerciales.

Obviamente, de esto al concepto de una AGI (Inteligencia General Artificial) capaz de aprender tareas intelectuales similares a las humanas, hay un abismo. En todo caso, muchos son los que piensan que ni siquiera deberíamos estar hablando de AI porque el término -que, además, engloba hoy un montón de cosas diferentes-genera mucha confusión.

DE ZOMBIS FILOSÓFICOS Y LITERATURA ZOMBI

Los estudios sobre la consciencia, esenciales para la filosofía moderna y con importantes antecedentes en la filosofía clásica, adquirieron gran auge en la segunda mitad del siglo XX a partir del surgimiento de las ciencias computacionales y el desarrollo de sistemas de inteligencia artificial.

El tema ha generado diferentes conceptos. Uno de ellos es el de “Zombie Filosófico”, planteado en 1974 por Robert Kirk (KIRK, 1974) que refiere a la posible existencia o no de un hipotético ser físicamente idéntico a un ser humano pero carente de la posibilidad de sentir o de tener experiencias subjetivas.

En 1983, por su parte, el filósofo John Searle concebía el experimento mental de la “habitación china” (SEARLE, 1980)donde imaginaba una habitación completamente aislada del exterior salvo por una ranura en donde un hombre chino introducía hojas de papel con textos escritos en chino. Dentro de la habitación, estaba el propio Searle que no sabía nada de chino pero que estaba equipado con una serie de manuales y diccionarios que le indicaban cómo deben combinarse los caracteres. Así, él se las arreglaba para responder a los textos que recibía, devolviendo a su vez, por la misma ranura, sus respuestas chinas. El hombre chino, al recibir las respuestas, creía que dentro de la habitación había alguien que conocía su idioma.

Mediante este experimento, Searle intentaba rebatir la validez de la prueba de Turing. Turing sostenía, en 1950, que, si una máquina tenía la suficiente capacidad de memoria, sería capaz de pensar como un humano. Para él, el pensamiento era simplemente computación. (TURING, 1950) Para Searle, por el contrario, pasar la prueba de Turing no era prueba suficiente de inteligencia. Si bien una máquina puede realizar una acción sin siquiera entender lo que hace y el por qué lo hace, el pensamiento implica no sólo la manipulación de símbolos (gramática o sintaxis), sino también poseer una capacidad semántica para ser consciente de los significados de los símbolos que está manipulando.

Como sea, un zombi filosófico sólo podría crear arte y literatura zombi.

EL TEOREMA CENTRAL DEL LÍMITE

Hoy los laboratorios desarrollan programas cuyos lenguajes semejan al lenguaje natural humano mediante el NLP (Natural Language Processing). Estos programas pueden escribir de forma indistinguible de las de un humano en muchas áreas, por ejemplo, en el campo del marketing o en copywriting, donde suelen ser incluso más eficientes y mucho más rápidos. De hecho, hoy son las máquinas las que escriben la mayor parte de las publicidades, muchos de los artículos periodísticos y hasta algunas novelas comerciales.

A partir de técnicas como las de GPT (Generative Pre-trained Transformer), las máquinas emulan la escritura humana siendo para ello alimentadas con millones de datos -diálogos de películas, contenidos de las redes, materiales de bases de datos-.

Como en la Habitación de Searle, las máquinas no tienen idea del significado de sus enunciados, pero sí saben combinar correctamente los signos y, además, han desarrollado un “sentido común probabilístico”.

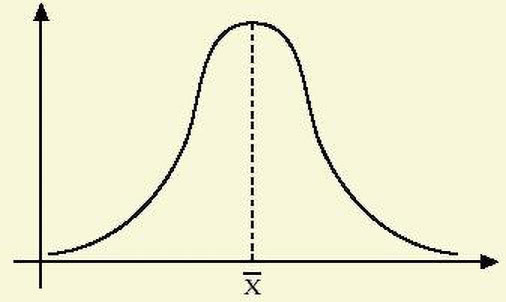

La Inteligencia Artificial utiliza modelos que aplican técnicas estadísticas y algoritmos a grandes volúmenes de datos a fin de responder de una manera automática a la información que se le solicita. Un concepto central de la estadística y la teoría de las probabilidades es el del Teorema Central del Límite (TCL), que refiere a la tendencia de los resultados de una variable aleatoria a acercarse a la distribución “normal”, “central” o “gaussiana” -es decir, al centro de la campana de Gauss- descartando sus laterales. Esto significa que los programas creados a partir de enfoques probabilísticos se ajustan con la mayoría, descartan la minoría y se alimentan con repeticiones, convenciones y clichés.

Estos programas de AI que permanecen ligados al paradigma de la hipérbole propio de la lógica de la cantidad, la mayoría y las tendencias difícilmente podrán ser útil en el campo de la poesía porque la poesía es otra cosa. Para Michel Foucault, por ejemplo, la poesía poseía un carácter marginal respecto del lenguaje y en esto se parecía un poco a la locura. Ambas se presentaban como experiencias radicales en las que el sentido del mundo se veía subvertido. El poeta y el loco poseen una relación particular con las palabras. Comparten su condición de otredad o “extranjeridad” respecto del lenguaje y, en este sentido, se enfrentan directamente con el discurso hegemónico. (FOUCAULT, 2019)

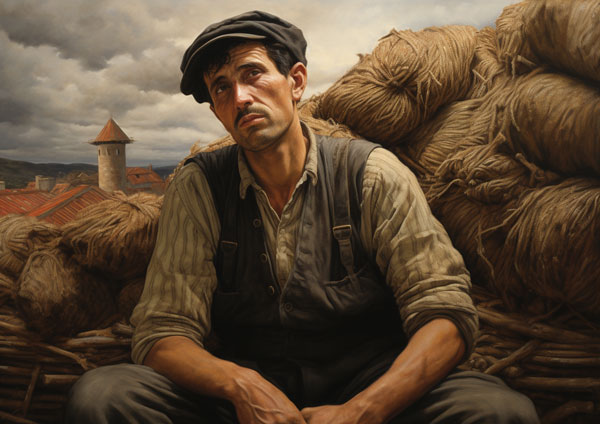

Pero los programas de IA no sólo permanecen ligados a la lógica de la mayoría y las tendencias. Junto con ella, llevan implícita una particular visión del mundo. En la década de 1960, Umberto Eco contaba que muchos de los teóricos de la comunicación sostenían que “el medio no transmite ideologías sino que es la ideología misma”. (ECO, 1987) Contrariamente a la idea de “neutralidad” que uno suele arrogarle a la tecnología, esta posee siempre un fuerte contenido ideológico. Así, los programas de IA están creados a partir de algoritmos y bases de datos cuidadosamente diseñados y elegidos. Aquellos a los que tenemos acceso, por ejemplo, han sido entrenados con descomunales datasets que reproducen la manera de ver el mundo y los prejuicios del público medio estadounidense. Un ejemplo cualquiera: le pedí al Midjourney que generara la imagen de un trabajador estadounidense y otra de un trabajador español. El primer resultado que obtuve fueron estas dos imágenes.

Podemos ver el diferente tratamiento dado a ambas imágenes. En un caso, se trata de un trabajador industrial joven de ancha mandíbula, con un casco que mira al frente orgulloso y en cuyo fondo se ve una bandera de los EEUU, aludiendo a su orgullo, su patriotismo y a la manera en que su trabajo contribuye a hacer fuerte su nación. En el otro, se trata de un trabajador rural mal trajeado, con un chaleco desabrochado y una boina, con barba y bigote a medio crecer, con el rostro de tres cuartos de perfil, arrugas en su frente y la mirada perdida en algún lugar del cielo. Este ejemplo al azar muestra cómo los programas de IA replican los estereotipos, los lugares comunes y las relaciones de poder que existen en nuestras sociedades y reflejan las percepciones y opiniones de la mayoría social. A la hora de explicar o juzgar, serán siempre estas visiones las que predominen al quedar las perspectivas que no pertenecen al mainstream fuera de la cima de la curva de Gauss.

LAS VANGUARDIAS CONTRA EL SENTIDO COMUN

Después de esta digresión semiológica, vuelvo al tema de la poesía. Los poetas de las vanguardias históricas, los de las neovanguardias y los poetas digitales experimentales, siempre hemos buscado el trastocamiento de los códigos literarios y poéticos tradicionales y confrontar con el lenguaje común. Cambiar las leyes lingüísticas equivale a cambiar la manera de percibir el mundo y a cambiar un determinado orden de cosas dado.

A fin de destruir ese orden, los dadaístas, por ejemplo, apuntaban a su base misma, el lenguaje, buscando romper las leyes discursivas y sus lógicas subyacentes. En el Manifiesto Dadá de 1918, Tristán Tzará adhería al principio de contradicción continua con sentencias como la siguiente: “Odio el sentido común. (…) Dadá, dadá, dadá es el entrelazado de los opuestos y de todas las contradicciones e inconsistencias que componen la vida”. (TZARA, 2015)

Ideas similares eran sostenidas, en la segunda mitad del siglo XX, por el movimiento letrista, que proclamaba igualmente la necesidad de renovar la poesía para transformar radicalmente la sociedad propiciando nuevos alfabetos y alterando los sistemas escriturarios tradicionales. El situacionismo apuntaba contra el automatismo de la vida cotidiana y atacaba los discursos sociales a partir de técnicas como el détournement. Poetas como Brion Gysin y William Burroughs, experimentaban por su parte con técnicas de cut-up. El lenguaje controlaba y determinaba los sentidos; restringía y cerraba los significados sobre las cosas. Así, ejercía el control sobre los seres humanos, encerrándolos en patrones de percepción y pensamiento convencionales que reproducían los sistemas de micro-control social y los hábitos en el pensar y sentían la necesidad de rebelarse frente a esto.

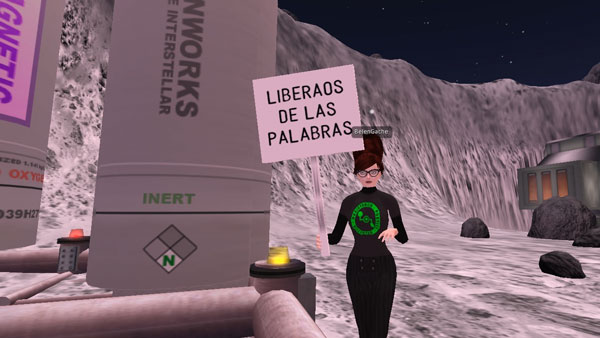

En mi videoperformance en Second Life El Discurso de Liberación de los Poetas (2019), mi avatar camina por la superficie lunar leyendo el texto del discurso y blandiendo en la otra mano un cartel con la inscripción “Liberaos de las palabras”. La pieza está realizada a partir de técnicas de aleatoriedad, de collage y de cut up.

KUBLAI MOON: EL ROBOT AI HALIM Y LA RESISTENCIA POÉTICA GALÁCTICA

En 2013, comencé a trabajar en el proyecto transmedia Kublai Moon. Este consistía en un blog ficción, la novela de ciencia ficción lingüística Kublai Moon, un generador automático de poemas, un libro de poesías -Poesías de las Galaxias Ratonas-, una serie de performances en Second Life, una tipografía inventada -la Ratona Sans-, diferentes materiales gráficos, una serie de performances, etc.

La trama de la novela está ambientada en la luna y narra las aventuras de Belén Gache, que es una poetisa, y del robot AI Halim X-9009. En la narración, la figura del robot contrasta con la de los humanos porque, paradójicamente, siempre parece haber en él más «humanidad» que en estos últimos. Él está obsesionado por entender qué es la poesía y, durante el transcurso de la historia, desempeñara un rol relevante en la revolución lingüística llevada a cabo por la Resistencia Poética Galáctica que pretende despertar a los humanos de la hipnosis colectiva en la que los ha sumido el lenguaje hegemónico.

El robot termina siendo “asesinado” por la misma firma que lo ha creado mediante un mecanismo de obsolescencia programada. Él, que es sólo una máquina, se ve así convertido en un mártir de la poesía. Belén Gache deberá recuperar un complejo algoritmo creado por el robot para componer poemas y poner en línea un generador automático de poemas al que se accede, en la novela, mediante un código QR impreso en sus páginas finales.

Los textos originarios del proyecto Kublai Moon -los blogs ficción-, fueron escritos en 2013, 2014 y 2015 respectivamente. En esos años, cuando concebí al robot AI-Halim apenas se hablaba de la inteligencia artificial aplicada al lenguaje. Sí existían asistentes personales como Siri (2011). Cortana de Microsoft y Alexa son ambas de 2014. Fue recién a partir de 2015 que comienzan a popularizarse modelos generativos de lenguaje a partir de algoritmos de inteligencia artificial. Por ejemplo, los Generative Pre-trained Transformer, el GPT-2, el GPT-3, el GPT 4, es decir, las diferentes generaciones de modelos predictivos de lenguaje de Open AI que son capaces hoy de escribir textos indistinguibles de los textos humanos.

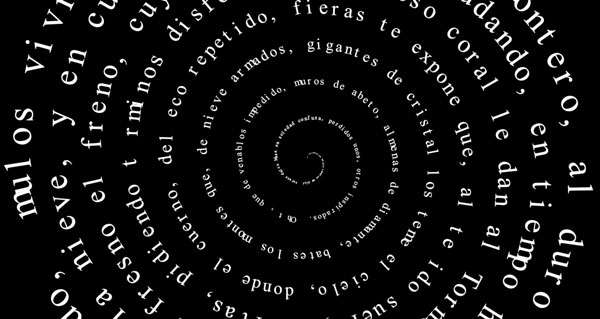

LOS ALGORITMOS ILEGALES DEL SPIRAL WORD

En mi novela, Brush Strokes, un miembro de una célula clandestina de la Resistencia Galáctica de Poesía, trabaja en la Corporación de Data Mining Tera Tang. Él descubre unos algoritmos ilegales que la compañía aplica al programa Spiral Word, el procesador de textos más utilizado en el planeta Tierra. Mediante la aplicación de estos algoritmos, al leer cualquier texto escrito en el Spiral Word, los renglones abandonaban su clásica diagramación paralela y devenían espirales sin fin que comenzaban a rotar, sumiendo al usuario/lector en una hipnosis cada vez más profunda que culminaba con un irreversible lavado de cerebro.

Pero las navegaciones de Strokes por sitios clasificados fueron descubiertas por la compañía y Strokes fue detenido por la Brigada de Salud Lingüística. Más tarde, en la novela, un grupo de hackers de la Resistencia logra desactivar los algoritmos ilegales implantados en el Spiral Word. Pero, contrariamente a todos sus pronósticos, apenas enterados de que sus lecturas habían sido desposeídas del programa ilegal de hipnosis colectiva, los lectores zombis reaccionan marchando por las ciudades y exigiendo que el programa vuelva a ser inmediatamente instalado.

En Kublai Moon existen dos grupos que antagonizan con los poetas: los metrofóbicos y los monométricos, es decir, aquellos que quieren poseer las palabras y aquellos que buscan destruirlas. Los verdaderos poetas se resisten a los diferentes discursos hegemónicos de los mercados y de los medios masivos. También se resisten a los “formadores de opinión” y a la memética, que es por definición, monométrica.

La diferencia entre metrofóbicos y monométricos puede ser comparada con la de las distopías de Un Mundo Feliz (Huxley, 1932) y 1984 (ORWELL, 1949). Por una parte, tenemos un Estado brutal donde prima el control asfixiante, la hipervigilancia masiva, la represión política y social. Por la otra, una dictadura del bienestar y la felicidad perpetua y artificial llevada adelante por un Estado que domina mediante el placer, la farmacodependencia, el entretenimiento permanente de sus ciudadanos; que elimina todo contenido, todo pasado, todo valor moral o cultural, todo pensamiento individual.

ALGORITMOS PROPIOS Y AJENOS. LAS ALUCINACIONES DE LA IA

En su condición de máquina, AI-Halim, introduce un antídoto frente al virus de control que afecta tanto al pensamiento como al lenguaje de los humanos. Sus investigaciones sobre el lenguaje poético lo han llevado a crear su propio algoritmo y a alimentarse con datos que él mismo ha escogido y a descartar aquello con los que lo habían dotado en la compañía multinacional que lo había fabricado. Paradójicamente, mientras que el robot llega a poseer cuestionamientos críticos al punto de «morir» intentando llevar adelante la revolución lingüística para desprogramar a los humanos, los humanos se dejan programar por los lugares comunes, convirtiéndose en máquinas replicantes.

La cuestión aquí es quien utiliza algoritmos propios y quien utiliza algoritmos ajenos. La poesía que ha desarrollado AI-Halim es importante para la Resistencia porque, lejos de conformarse con los sets de datos con los que lo han alimentado en la compañía Kanasawa -impulsada por capitales monométricos-, él ha creado su propio algoritmo.

Es verdad que en los llamados LLM o “Large Language Models” se ha observado lo que se conoce como “alucinaciones”. Se trata de ciertos outputs “creativos” que, cada tanto, se registran en las performances de las máquinas y que suelen compararse con las ilusiones humanas paranóicas. (HUBERMAN, 2023) Esto se debe a la “memoria asociativa”, que es un componente clave para el funcionamiento de los LLM. Esta memoria se da a partir nodos interconectados que van constituyendo el horizonte semántico con el cual el modelo es entrenado. Si este horizonte semántico es demasiado amplio, a veces sucede que se activan nodos distantes no relacionados directamente con las búsquedas del usuario y que son, por lo tanto, indeseables. Éste se corrige o bien reduciendo el horizonte semántico del modelo o “penalizando” al modelo cada vez que incurre en uno de estos actos creativos.

PSITAQUISMOS, VENTRILOCUISMOS, KARAOKE: HABLANDO CON LAS PALABRAS DE OTROS

Lo cierto es que los programas de IA no son particularmente generativos ni particularmente inteligentes, tal como quisieran los empresarios detrás de esta industria. Lo que producen es más bien un contenido automatizado derivado de miles de textos e imágenes creadas por seres humanos y cuyo resultado es un aburrido producto comercial diseñado para facilitar y hacer más eficiente la integración corporativa.

Se conoce como psitaquismo a los discursos o escrituras mecánicas o repetitivas que semejan el habla de los loros. Básicamente, el término hace referencia a quien, también como un muñeco de ventrílocuo, habla con palabras de otro. Esta situación puede darse a partir de un amplio espectro que va desde la ecolalia hasta la repetición automática de argumentarios de marketing o argumentarios políticos y es necesario notar que, más allá de los discursos generados por los programas de IA, el 99 % de los discursos que circulan socialmente consisten en meras repeticiones enunciadas sin la menor distancia crítica.

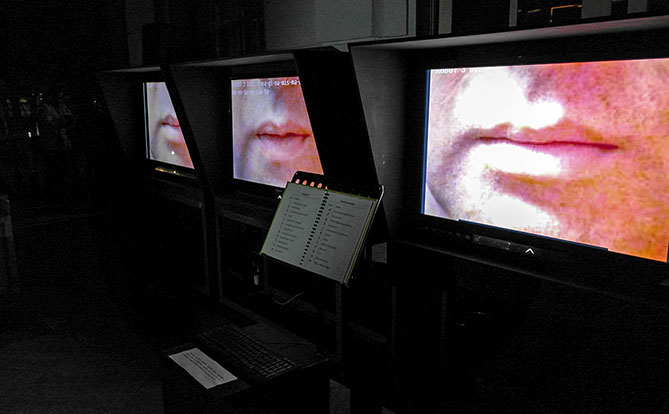

A partir del tema del psitaquismo, realicé en 2011 mi pieza Radikal Karaoke, que luego fue incorporada al archivo de Electronic Literature Organization (ELO). Se trata de una serie de poemas aleatorios consistentes en discursos políticos pre-escritos basados en consignas sin contenidos específicos, dando por resultado una serie de clichés lingüísticos cuya única meta, al igual que los virus, es repetirse a sí mismos. Al igual que el karaoke convierte en supuesto cantante y protagonista a quien lo utiliza, mediante el uso de este dispositivo cualquiera podrá tener la ilusión de verse convertido en un líder político y arengar a las masas.

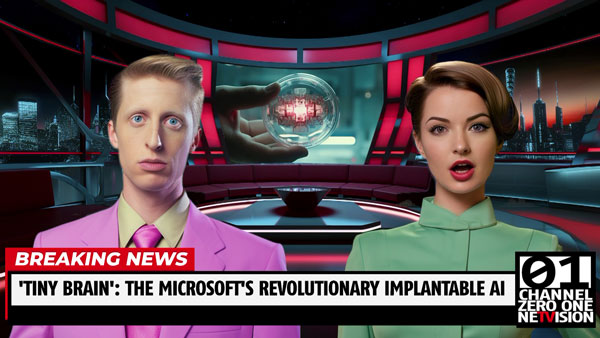

Otra obra concebida a partir de estas ideas pero realizada completamente con Inteligencia Artificial es Channel 01, del artista Gustavo Romano, que aborda el tema del psitaquismo pero también los de la postverdad, las fake news y la escritura automática.

La pieza se apropia de los discursos de los medios de comunicación masiva. Se trata de un canal de noticias totalmente generado por IA: imágenes, animaciones, personajes, textos. Se trata de un canal audiovisual automático de noticias, basado en algoritmos de “contra” inteligencia artificial de desarrollo propio. A partir de material tomado de la propia web, la señal captura, reorganiza y reproduce hechos alternativos y distópicos. Según sostiene el propio artista: “En un futuro próximo, serán los algoritmos los que comuniquen las noticias. El "pensamiento" maquínico no evalúa los hechos; si estos son reales o alternativos, si se trata de verdad o posverdad. Los medios hablarán, narrarán, discurrirán, sin evaluar criterios de veracidad sino ajustando el nivel de verosimilitud del mensaje para blindar el pacto ficcional con el receptor.”

CONCLUSIÓN: LA LUCHA POR EL ALGORITMO

La IA aplicada a la generación de textos o imágenes es una herramienta maravillosa, pero los programas comerciales a los que podemos acceder están destinados principalmente a tareas ligadas a los campos de las finanzas, el márketing, el copywriting.

Yo escribí recurrentemente sobre el tema de las máquinas que escriben. En 2008 escribí un libro donde hablaba, por ejemplo, de la cabeza parlante del mago Roger Bacon, en el siglo XIII o, ya en el siglo XVII, de la estatua parlante que John Wilkins tenía en su jardín. La idea de que las máquinas puedan ya no sólo hablar, sino adquirir una inteligencia similar a la de los humanos aparece recurrentemente en la literatura, generalmente, como peligrosa. Por ejemplo, en la novela Erewhon, de Samuel Butler (1872), donde el autor se refiere por primera vez a la posibilidad de que las máquinas puedan desarrollar conciencia (1) o en la obra de teatro R.U.R. -Robots Universales Rossum- escrita por el autor checo Karel Capek (1920) que se hizo famosa por ser allí donde por primera vez aparece la palabra “robot” y donde una serie de “humanos artificiales” construidos exclusivamente para trabajar -que son unos seres que pueden hacerse pasar por humanos y que pueden pensar- se rebelan contra sus fabricantes.

También encontraremos el motivo en los de Isaac Asimov sobre robots, en cuentos de Arthur C. Clarke como "Dial F for Frankenstein", y, por supuesto en la película 2001-Odisea del espacio- basada también en un texto de Arthur Clarke-, en donde el ordenador a bordo de una estación espacial -HAL 9000-, al enterarse de que va a ser apagado, se rebela y pretende matar a la tripulación. Mi robot AI Halim X-9009 es, por supuesto una cita al HAL de 2001.

Sin embargo, lo que está en juego aquí no es la confrontación entre un lenguaje de los humanos y un lenguaje de las máquinas. Con lo que nos enfrentamos hoy es con la disyuntiva entre la tiranía del lenguaje monométrico y la subsistencia de los lenguajes individuales y diversos. Hoy los programas que utilizan IA no sólo pueden escribir como los humanos. También pueden crear posts en las redes sociales, generar etiquetas, utilizar herramientas de marketing para determinar sus destinatarios según sus diferentes targets demográficos, incluso leer los textos escritos por otras máquinas. Pero la IA está entrenada con el habla social hegemónica y está destinada exclusivamente a reproducirla. Lo que promueve el uso de la IA es un pensamiento automático, un pensamiento ventrilocuista que no cuestiona el algoritmo que lo produce. Dada la omnipresencia de estas tecnologías, pronto todos nos veremos convertidos en “zombies filosóficos” en un mundo zombie.

En este escenario, el rol de los poetas será el de resistirse al juego monométrico, a la lógica cuantitativa de los likes y a la cultura de las tendencias. A partir del reconocimiento del rol que la palabra juega en la reproducción del orden social y las subjetividades dadas, la resistencia de los poetas pasa por salirse de esta lógica y evidenciar las estrategias discursivas del lenguaje hegemónico. Como sostiene Slavoj Zizek, el lenguaje como “gran Otro”, tal como lo definía Lacan, no es un agente de sabiduría con cuyo mensaje debemos sintonizar sino un lugar en el que priman la indiferencia y la estupidez. (ZIZEK, 2016) Para lograr que el lenguaje hable de verdad, éste debe ser torturado -cortado, retorcido, deconstruido-, y la forma más eficaz para torturar la lengua se llama poesía.

Como decía mi avatar en la video-performance del Discurso de Liberación de los poetas:

Poetas:

¡Liberaos del discurso que os oprime!

¡Luchad contra las cárceles del lenguaje!

¡Liberaos de las palabras!

Belén Gache

NOTAS

(1) En su colaboración con Félix Guattari, Anti-Edipo (1972), Deleuze se basa en «El libro de las máquinas» de Butler para abordar el tema de las “máquinas deseantes”.

BIBLIOGRAFIA

Eco, Umberto (1987), La estrategia de la ilusión, Buenos Aires, Lumen/de la Flor

Foucault, Michel (2015) La gran extranjera, para pensar la literatura, Buenos Aires: SXXI

Foucault, Michel (2019), Folie, langage, littérature, Paris, Vrin

Gache, Belén (2017), Kublai Moon, Madrid, Sociedad Lunar

Huberman, Bernardo (2003), “Hallucinations and Emergence in Large Language Models”, https://www.researchgate.net/publication/373296744_Hallucinations_and_Emergence

_in_Large_Language_Models (consultado 23-8-2023)

Kirk, Robert (1974), "Sentience and Behaviour", Mind 83, p. 43–60

Searle, John. R. (1980), “Minds, brains, and programs”, Behavioral and Brain Sciences 3, p. 417-457

Turing, Alan, “Computing Machinery and Intelligence”, https://www.abelard.org/turpap/turpap.php (consultado el 25-8-2023)

Tzará, Tristan (2015), Siete manifiestos dada, Barcelona, Austral

Zizek, Slavoj (2016), «Language, Violence and Nonviolence”, International Journal of Zizek Studies, volume 2, n3